0

发表咨询在线!

时间:2018-07-25 16:57:43 所属分类:智能科学技术 浏览量: 248

摘要:为更好地应对跟踪过程中复杂的场景变化问题,提出一种采用多种特征融合进行跟踪的方法。算法在粒子滤波的框架下,通过在跟踪过程中对每一个特征进行不确定性度量,计算动态的特征权值,从而完成了自适应的特征融合。利用颜色、空间和纹理特征的互补特

摘要:为更好地应对跟踪过程中复杂的场景变化问题,提出一种采用多种特征融合进行跟踪的方法。算法在粒子滤波的框架下,通过在跟踪过程中对每一个特征进行不确定性度量,计算动态的特征权值,从而完成了自适应的特征融合。利用颜色、空间和纹理特征的互补特性,提升了算法的跟踪性能。实验结果表明,算法能够很好地适应目标尺度、旋转、运动模糊等复杂场景的变化。与近年来流行的算法相比,所提出的算法具有明显优势,能够很好地完成跟踪任务。

关键词:视觉跟踪;特征融合;颜色;空间;纹理

1 引 言

视频序列中的目标跟踪是计算机视觉领域的一个重要问题,具有广泛的应用,如视频监控[1]、机器人学[2]、自动驾驶[3]等。在目标跟踪中,外观模型是目标表示的重要因素,且研究者们提出了许多不同且有效的特征描述子。由于计算方便,单一特征描述子被广泛应用在视觉跟踪的外观模型中。但是,单一特征描述子通常不足以描述目标的复杂特性和变化,而结合多个特征描述子进行目标表示能够提高视觉跟踪的性能。因为不同特征能够提供互补的目标信息。

近年来,部分研究者们提出了一些多特征融合的视觉跟踪算法,用不同特征来共同进行目标表示。Ma 等人[4]基于加权熵的概念融合了多个特征,用该方法评估目标和背景之间的差异度,并通过最小化加权熵的方式寻找最优的特征组合。Dou 等人[5]在粒子滤波的框架下结合了相互作用的多个模型,包括 CBWH、 CLTP 和 HOG。Chen 等人[6]构造了复杂的结构体来综合从局部外观中提取到的信息,并提出了一种新的模板匹配方式。鲁琴等人[7]提出了一种基于多尺度混合模型多特征融合的单目标跟踪算法。但这些方法往往具有较高的运算复杂度,难以满足实际应用中对跟踪速度的要求。

本文提出了一种新的多特征融合跟踪算法,在粒子滤波的框架下通过对每一特征进行不确定性度量,从而根据特征的不确定性调整其对跟踪的影响,实现了自适应的多特征融合。此外,由于颜色特征具有较强的鲁棒性,对旋转、缩放等变化不敏感,难以应对光照变化;空间特征包含了目标的空间信息,能够弥补颜色直方图中对空间信息丢失的不足;纹理特征对光照变化不敏感,且不容易被局部的偏差影响。因此,将这三种具有互补性质的特征融合在一起,共同进行目标表示,能够提供更为丰富有效的目标信息。

基于以上讨论,本文采用不确定性度量的方法融合了颜色、空间和纹理三种特征,提高了算法的整体跟踪性能。

2 相关基础理论

2.1 粒子滤波

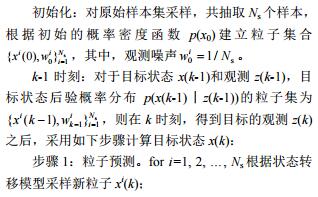

相较于许多常见的滤波方式,粒子滤波体现出了更好的性能,尤其在非线性或非高斯环境。它被广泛应用于采用视觉特征、几何特征和运动特征进行的视觉跟踪中。粒子滤波的主要步骤如下:

通过以上步骤,就可以实现基于粒子滤波的目标跟踪。其中,由于目标的运动特性难以预测,本文选取最简单常用的一阶线性系统作为状态转移模型:

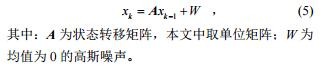

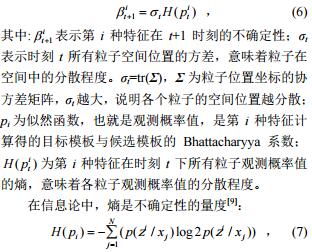

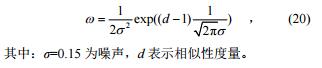

2.2 特征不确定性在跟踪过程中,不同场景下各个特征对目标位置估计的准确度是不同的。文献[8]提出了一种对特征进行自适应的不确定性度量方法,其具体过程如下:

H(pi)的值越小,说明特征 i 对目标的位置估计越准确。根据对式(6)的分析可知,特征的不确定性不仅包含了粒子的空间分布情况,还体现了似然函数 pi的尖锐程度。对于粒子的空间分布,目标位置是通过对各个粒子进行加权求和估计得到的,在 t 时刻,粒子分布越集中,σt 越小,特征的不确定性越小,反之则特征的不确定性越大。而对于似然函数,其尖锐程度越高,说明观测概率值只是集中于少数的几个粒子,则该特征的鉴别能力越强。

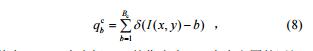

3 本文跟踪算法 3.1 特征提取 3.1.1 颜色直方图颜色特征是被广泛应用于图像处理领域的一种特征,它对图像区域的尺寸、方向和视角依赖性较小,因此具有较高的鲁棒性。而颜色直方图是颜色特征的一种常见形式,具有计算简便、处理便捷的特点。图像 I 的颜色直方图提取表达式为[10]

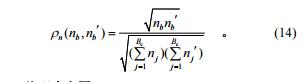

其中:I(x, y)为坐标(x, y)的像素点,Bc为直方图的区间数,b 为区间变量。并采用 Bhattacharyya 系数[11]作为相似性度量。 3.1.2 空间直方图二阶空间直方图包含了直方图每一个区间中像素空间均值和协方差,补充了颜色直方图中丢失的像素空间分布信息。图像二阶空间直方图提取表达式为[12]

3.1.3 纹理直方图纹理特征对整体的光照变化不敏感,且不易被局部的偏差或变化影响,在模式匹配中具有较大优势。本文中,通过采用 LBP 算子[13]来实现纹理特征的提取。如图 1 所示,本文采用的 LBP 算子是一个大小为 3×3 矩形块。以中心灰度值作为阈值,比较它与邻域的 8 个灰度值的大小,从而进行二值化。再将 3×3 矩形的值按一定顺序表示为一个二进制数,以此数值 (0~255)作为该 LBP 的值。

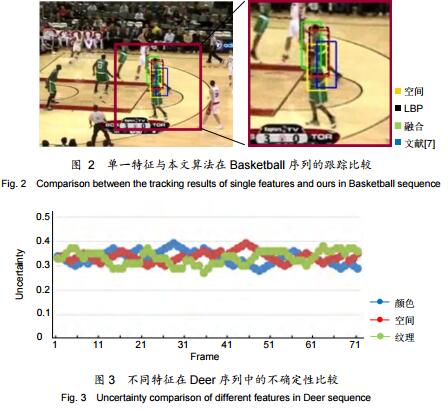

3.1.4 特征比较为比较不同特征单独跟踪时展现出的不同特性,对本文采用的颜色、空间及纹理特征分别进行了跟踪实验,并比较三种特征单一进行跟踪与本文方法融合后跟踪的实验结果,如图 2 所示。从实验结果中可以看出,颜色特征容易受到颜色相近物体的干扰,空间特征根据像素分布情况容易出现跟踪框漂移的问题,纹理特征则更倾向于输出纹理信息丰富的区域。

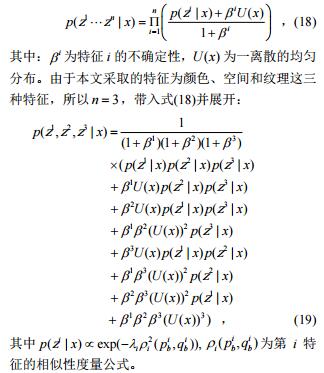

总的来说,三种特征的融合能够实现更为准确的跟踪结果。结合 Deer 序列从图 3 的不确定性比较中可以看出,当前景与背景颜色区分度较大时,颜色特征的不确定性较低,当背景出现颜色干扰时,颜色特征的不确定性较高,且此时纹理特征的不确定性较低。在候选区域像素分布干扰较小时,空间特征的不确定性也相应降低。

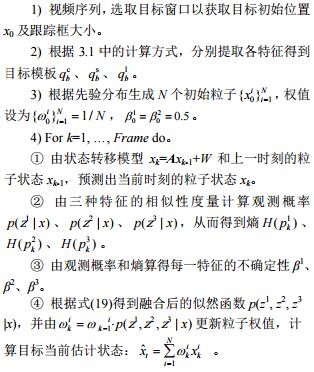

3.2 融合框架文献[8]提出的融合策略首先假定 n 种特征是条件独立的,然后在每一种特征的观测概率值上加一个正比于特征不确定性的均匀分布,进行归一化处理后取乘积,具体表达式如下:

3.3 算法流程综上所述,本文基于颜色、空间和纹理信息的目标跟踪算法的完整流程如下:

⑤ 根据更新后的粒子权值分布决定是否进行重采样操作。

⑥ 输出第 k 帧的跟踪结果 ˆk x 。 5) End。4 实 验为验证本文算法的性能,通过 MATLAB 2009a 进行编程实现,并在内存 4 GB 的计算机上进行了大量实验测试。本文采用 ACT[14]、ASLA[15]、DLT[16]、 DSST[17]、LLC[18]作为对比算法,这些算法均是近年提出的算法中性能较好、研究热度较高的算法。 4.1 参数设置在本文算法的实验中,通过参考经典文献及反复调试,设置参数如下:粒子数为 200,方差为 0.35,颜色空间为 RGB,区间数为 8,相似性度量与粒子权重值的转化公式为

4.2 定性分析

图 4 展示了实验中部分具有代表性的结果。不同算法采用了不同颜色的矩形框表示,左上角的数字为图像帧数。David3 序列中,目标分别经历一大一小两个遮挡物。从实验结果上看,在所有算法中,只有本文算法能够全程准确地跟踪目标。其余算法均有不同程度的目标丢失情况。Deer 序列中,目标经历了相似物遮挡、运动模糊等复杂场景影响,但本文算法始终能够较好地跟踪目标,没有出现丢失的情况。Football1 序列中,目标运动速度较快,且目标周围相似物较多,背景扰乱较大。但相较其他算法而言,本文算法能够更准确地跟踪目标。Lemming 序列中,目标经历了全遮挡、形变、尺度变化等,极易造成目标丢失,但本文算法的跟踪情况良好。Liquor 序列中,目标周围的瓶子以及瓶子的移动造成了相似物干扰和遮挡。

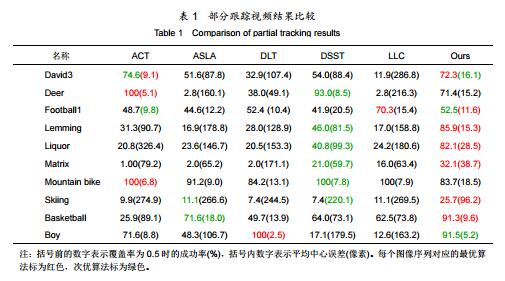

在该序列中,本文算法的跟踪情况相较其他算法而言更为准确。Matrix 序列中,背景颜色较暗,且有强烈的光照变化,仅本文算法能够较好地跟上目标。Mountain bike 序列中,背景是山体,纹理信息丰富,容易造成跟踪中的背景干扰,但本文算法能够全程准确地跟踪目标。Skiing 序列中,目标经历了旋转、快速运动、尺度等变化,而本文算法的跟踪效果最好。Basketball 序列中,目标经历了非刚性形变、遮挡、平面内旋转等变化,本文算法能够准确地全程跟上目标。Boy 序列中,目标经历了程度较大的运动模糊,相对于参考算法而言,本文算法能更好地克服运动模糊带来的不利影响,取得良好的跟踪效果。 4.3 定量分析为对算法进行定量分析,引入中心位置误差、精度和成功率[19]这三个评价指标。其中跟踪精度主要由算法在各个视频的中心位置误差进行统计得出,成功率则取决于跟踪结果与目标真实位置的覆盖率。

表 1 统计了图 4 所展示了 10 组序列的平均中心位置误差和成功率比较。从该表中可以看出,相较于对比算法,本文算法在大多数场景中能够更好地跟踪目标。Deer 序列中,本文算法位列第三,主要是由于该序列的背景中,反复出现了与目标在颜色、像素分布及纹理方面均十分相似的干扰项,影响了算法的跟踪性能。Mountain bike 序列中,背景的纹理信息十分丰富,且目标本身的结构导致初始帧中引入了较多背景像素,导致算法的跟踪不够精确。在其他序列中,本文算法均呈现出最优的性能。

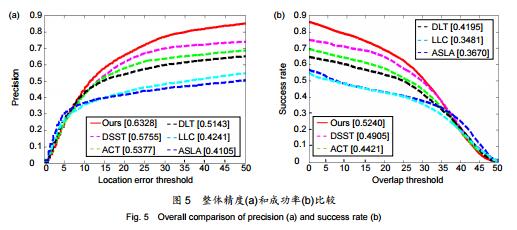

图 5 展示了 30 组视频的整体跟踪精度和成功率。从该图中可以看出,本文算法的精度和成功率值均是六种算法中最高的,整体跟踪性能最好,能够较好地适应不同跟踪环境及目标变化。 5 结 论考虑单一特征难以应对复杂的场景变化问题,本文提出了一种基于多特征融合的目标跟踪算法。首先,考虑到颜色、空间和纹理特征的互补特性,采用这三种特征共同进行目标表示。其次,通过在跟踪过程中计算特征的不确定性,动态地调整特征权值,完成融合过程。最后,利用粒子滤波框架,找出每一帧中与目标模板最相似的区域作为跟踪结果。基于以上过程,算法能够很好地完成跟踪任务,有效地实现目标跟踪。在 OTB2013 上,进行了 30 组视频实验对算法进行验证。实验的定性分析和定量分析证明了算法在多种复杂场景变化下仍能较好地进行目标跟踪。

参考文献

[1] Verma K K, Kumar P, Tomar A. Analysis of moving object detection and tracking in video surveillance system[C]//Proceedings of the 2nd International Conference on Computing for Sustainable Global Development, 2015: 1759–1762.

[2] Tsai F S, Hsu S Y, Shih M H. Adaptive tracking control for robots with an interneural computing scheme[J]. IEEE Transactions on Neural Networks and Learning Systems, 2018, 29(4): 832–844.

[3] Gu Q, Yang J Y, Zhai Y Q, et al. Vision-based multi-scaled vehicle detection and distance relevant mix tracking for driver assistance system[J]. Optical Review, 2015, 22(2): 197–209.

[4] Ma L, Lu J W, Feng J J, et al. Multiple feature fusion via weighted entropy for visual tracking[C]//Proceedings of 2015 IEEE International Conference on Computer Vision, 2015: 3128–3136.

[5] Dou J F, Li J X. Robust visual tracking based on interactive multiple model particle filter by integrating multiple cues[J]. Neurocomputing, 2014, 135: 118–129.

[6] Chen D P, Yuan Z J, Wu Y, et al. Constructing adaptive complex cells for robust visual tracking[C]//Proceedings of 2013 IEEE International Conference on Computer Vision, 2013: 1113–1120.

[7] Lu Q, Xiao J J, Luo W S. Single target tracking with multi-feature fusion in multi-scale models[J]. Opto-Electronic Engineering, 2016, 43(7): 16–21. 鲁琴, 肖晶晶, 罗武胜. 基于多尺度混合模型多特征融合的单目标跟踪[J]. 光电工程, 2016, 43(7): 16–21.

[8] Gu X, Wang H T, Wang L F, et al. Fusing multiple features for object tracking based on uncertainty measurement[J]. Acta Automatica Siniaca, 2011, 37(5): 550–559. 顾鑫, 王海涛, 汪凌峰, 等. 基于不确定性度量的多特征融合跟踪 [J]. 自动化学报, 2011, 37(5): 550–559.

[9] Liu Q, Tang L B, Zhao B J, et al. Infrared target tracking based on adaptive multiple features fusion and mean shift[J]. Journal of Electronics & Information Technology, 2012, 34(5): 1137–1141. 刘晴, 唐林波, 赵保军, 等. 基于自适应多特征融合的均值迁移红外目标跟踪[J]. 电子与信息学报, 2012, 34(5): 1137–1141.

[10] Li P H. An improved mean shift algorithm for object tracking[J]. Acta Automatica Sinica, 2007, 33(4): 347–354. 李培华. 一种改进的 Mean Shift 跟踪算法[J]. 自动化学报, 2007, 33(4): 347–354.

[11] Choi E, Lee C. Feature extraction based on the Bhattacharyya distance for multimodal data[C]//Proceedings of 2001 IEEE International Geoscience and Remote Sensing Symposium, 2001: 524–526.

[12] Yao Z J. A new spatiogram similarity measure method and its application to object tracking[J]. Journal of Electronics & Information Technology, 2013, 35(7): 1644–1649. 姚志均. 一种新的空间直方图相似性度量方法及其在目标跟踪中的应用[J]. 电子与信息学报, 2013, 35(7): 1644–1649.

[13] Zhao G Y, Pietikainen M. Dynamic texture recognition using local binary patterns with an application to facial expressions[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2007, 29(6): 915–928.

[14] Danelljan M, Khan F S, Felsberg M, et al. Adaptive color attributes for real-time visual tracking[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090–1097.

[15] Jia X, Lu H C, Yang M H. Visual tracking via adaptive structural local sparse appearance model[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1822–1829.

[16] Wang N Y, Yeung D Y. Learning a deep compact image representation for visual tracking[C]//Proceedings of the 27th Annual Conference on Neural Information Processing Systems, 2013: 809–817.

[17] Danelljan M, Hager G, Khan F S, et al. Accurate scale estimation for robust visual tracking[C]//Proceedings of the British Machine Vision Conference 2014, 2014: 1–11.

[18] Wang G F, Qin X Y, Zhong F, et al. Visual tracking via sparse and local linear coding[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3796–3809.

[19] Wu G F, Li J W, Yang M H. Online object tracking: a benchmark[C]//Proceedings of 2013 IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411–2418.

声明:①文献来自知网、维普、万方等检索数据库,说明本文献已经发表见刊,恭喜作者.②如果您是作者且不想本平台展示文献信息,可联系学术顾问予以删除.

转载请注明来自:http://www.zazhifabiao.com/lunwen/dzxx/znkxjs/43766.html

上一篇:位能负载条件下的变频调速系统设计

下一篇:电子技术课程设计改革观点